Google Search est capable de comprendre le langage humain à l’aide de plusieurs modèles d’IA qui fonctionnent tous ensemble pour trouver les résultats les plus pertinents.

Des informations sur le fonctionnement de ces modèles d’IA sont expliquées en termes simples par Pandu Nayak, vice-président de la recherche Google, dans un nouvel article sur le blog officiel de l’entreprise.

Nayak démystifie les modèles d’IA suivants, qui jouent un rôle majeur dans la façon dont Google renvoie les résultats de recherche :

- RankBrain

- Appariement neuronal

- BERT

- MAMAN

Aucun de ces modèles ne fonctionne seul. Ils s’entraident tous en effectuant différentes tâches pour comprendre les requêtes et les faire correspondre au contenu recherché par les chercheurs.

Voici les principaux points à retenir du regard en coulisse de Google sur ce que font ses modèles d’IA et comment tout cela se traduit par de meilleurs résultats pour les chercheurs.

Les modèles d’IA de Google expliqués

RankBrain

Le premier système d’IA de Google, RankBrain, a été lancé en 2015.

Comme son nom l’indique, le but de RankBrain est de déterminer le meilleur ordre pour les résultats de recherche en les classant en fonction de leur pertinence.

Bien qu’il s’agisse du premier modèle d’apprentissage en profondeur de Google, RankBrain continue de jouer un rôle majeur dans les résultats de recherche aujourd’hui.

RankBrain aide Google à comprendre comment les mots d’une requête de recherche sont liés aux concepts du monde réel.

Nayak illustre le fonctionnement de RankBrain :

« Par exemple, si vous recherchez « quel est le titre du consommateur au plus haut niveau d’une chaîne alimentaire », nos systèmes apprennent en voyant ces mots sur différentes pages que le concept de chaîne alimentaire peut avoir à voir avec les animaux, et pas des consommateurs humains.

En comprenant et en faisant correspondre ces mots à leurs concepts associés, RankBrain comprend que vous recherchez ce que l’on appelle communément un «prédateur au sommet».

Correspondance neuronale

Google a introduit la correspondance neuronale dans les résultats de recherche en 2018.

La correspondance neuronale permet à Google de comprendre comment les requêtes sont liées aux pages en utilisant la connaissance des concepts plus larges.

Plutôt que de regarder des mots-clés individuels, la correspondance neuronale examine des requêtes et des pages entières pour identifier les concepts qu’elles représentent.

Avec ce modèle d’IA, Google est en mesure de jeter un filet plus large lorsque nous analysons son index à la recherche de contenu pertinent pour une requête.

Nayak illustre le fonctionnement de la correspondance neuronale :

« Prenez la recherche « insights how to manage a green », par exemple. Si un ami vous demandait cela, vous seriez probablement perplexe. Mais avec l’appariement neuronal, nous sommes capables de lui donner un sens.

En examinant les représentations plus larges des concepts dans la requête – gestion, leadership, personnalité et plus encore – la correspondance neuronale peut déchiffrer que ce chercheur recherche des conseils de gestion basés sur un guide de personnalité populaire basé sur les couleurs.

BERT

BERT a été introduit pour la première fois en 2019 et est maintenant utilisé dans toutes les requêtes.

Il est conçu pour accomplir deux choses : récupérer du contenu pertinent et le classer.

BERT peut comprendre comment les mots sont liés les uns aux autres lorsqu’ils sont utilisés dans une séquence particulière, ce qui garantit que les mots importants ne sont pas oubliés dans une requête.

Cette compréhension complexe du langage permet au BERT de classer le contenu Web en fonction de sa pertinence plus rapidement que les autres modèles d’IA.

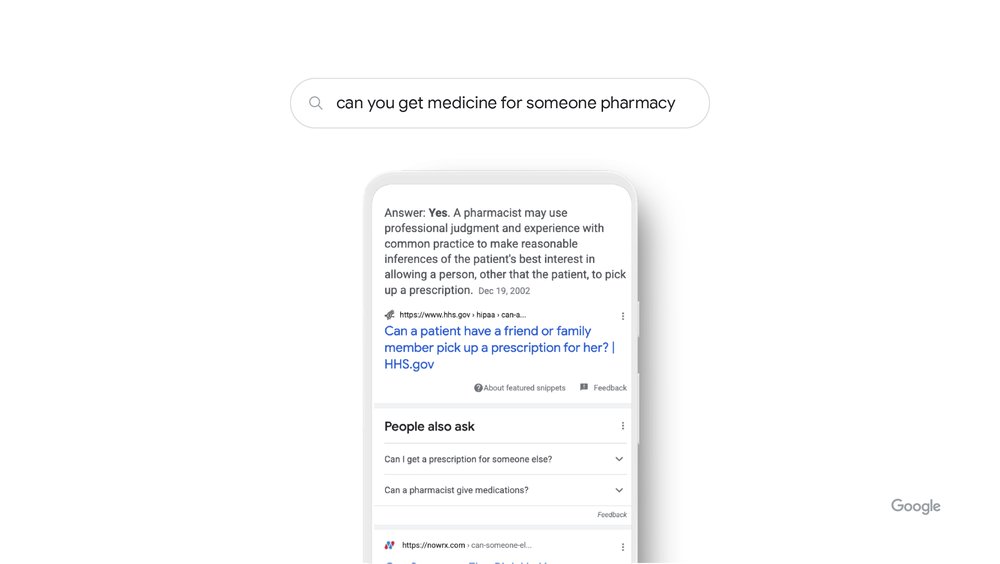

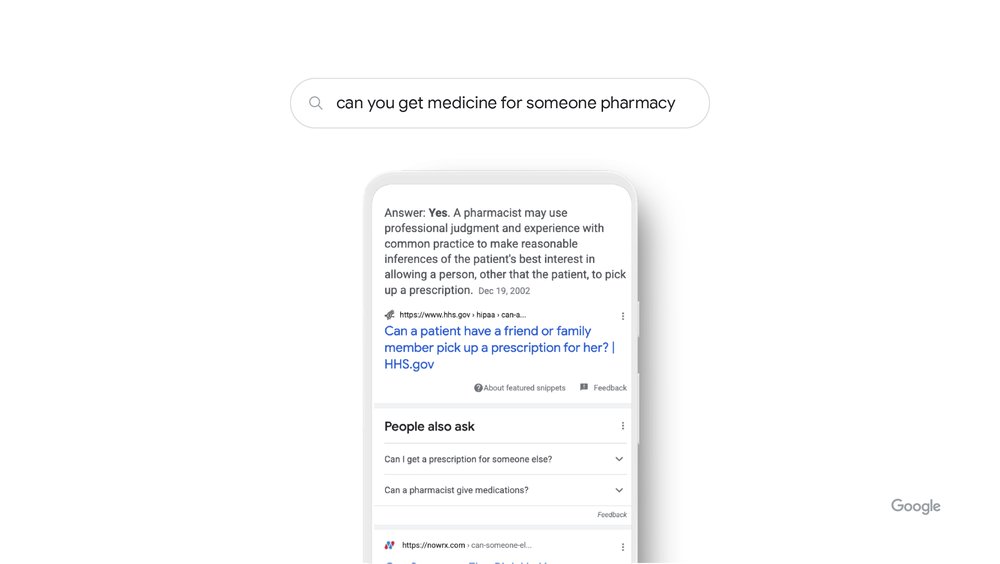

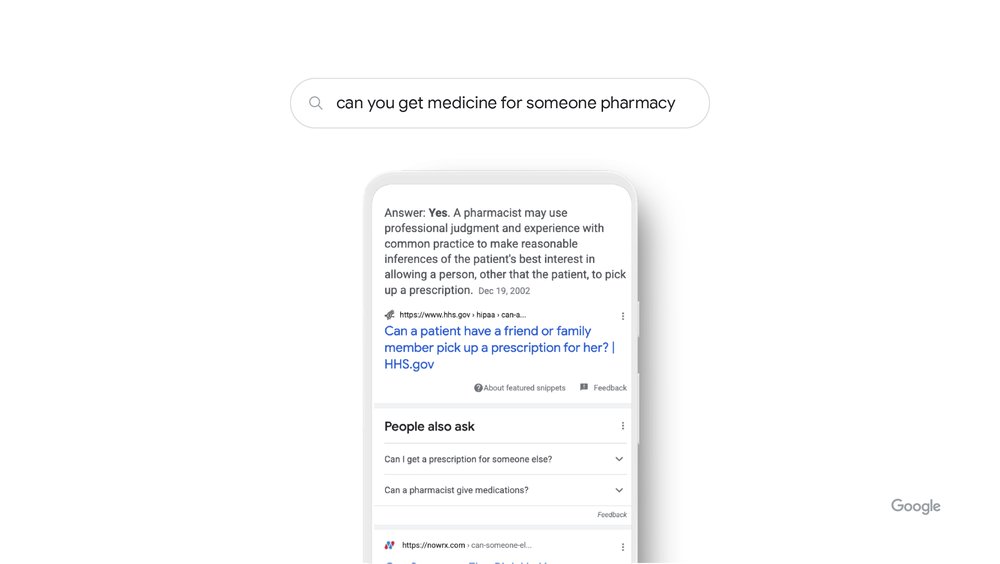

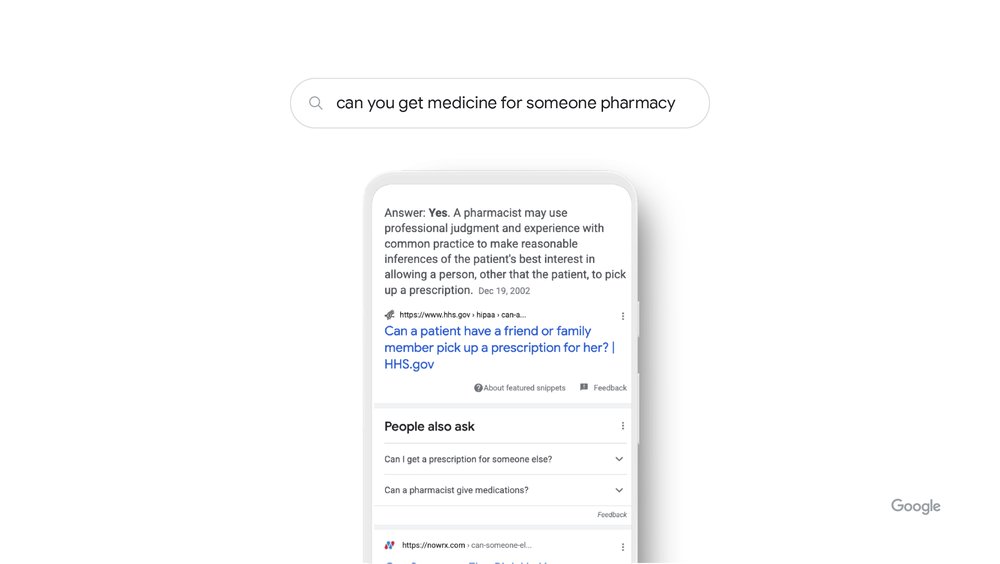

Nayak illustre le fonctionnement du BERT dans la pratique :

« Par exemple, si vous recherchez » pouvez-vous obtenir des médicaments pour quelqu’un pharmacie « , BERT comprend que vous essayez de déterminer si vous pouvez obtenir des médicaments pour quelqu’un d’autre.

Avant BERT, nous tenions cette courte préposition pour acquise, partageant principalement des résultats sur la façon de remplir une ordonnance. Grâce à BERT, nous comprenons que même de petits mots peuvent avoir de grandes significations. »

MAMAN

Le dernier jalon de l’IA de Google dans la recherche – le modèle unifié multitâche, ou MUM, a été introduit en 2021.

MUM est mille fois plus puissant que BERT et capable à la fois de comprendre et de générer un langage.

Il a une compréhension plus complète de l’information et de la connaissance du monde, étant formé dans 75 langues et de nombreuses tâches différentes à la fois.

La compréhension de MUM du langage s’étend aux images, au texte et plus encore à l’avenir. C’est ce que cela signifie lorsque vous entendez MUM être qualifié de « multimodal ».

Google en est aux premiers jours de la réalisation du potentiel de MUM, son utilisation dans la recherche est donc limitée.

Actuellement, MUM est utilisé pour améliorer les recherches d’informations sur le vaccin COVID-19. Dans les mois à venir, il sera utilisé dans Google Lens comme moyen de recherche en utilisant une combinaison de texte et d’images.

Résumé

Voici un récapitulatif de ce que sont les principaux systèmes d’IA de Google et de ce qu’ils font :

- RankBrain: classe le contenu en comprenant comment les mots-clés sont liés aux concepts du monde réel.

- Appariement neuronal: Donne à Google une compréhension plus large des concepts, ce qui augmente la quantité de contenu que Google peut rechercher.

- BERT: permet à Google de comprendre comment les mots peuvent modifier le sens des requêtes lorsqu’ils sont utilisés dans une séquence particulière.

- MAMAN: comprend les informations et les connaissances du monde dans des dizaines de langues et de multiples modalités, telles que le texte et les images.

Ces systèmes d’IA fonctionnent tous ensemble pour trouver et classer le contenu le plus pertinent pour une requête aussi rapidement que possible.

La source: Google

Image en vedette : Igor Golovniov/Shutterstock